|

|

|

|

Report: Umstieg auf eine skalierbare Linux-UmgebungMit allem rechnenKlaus Plessner |

|

Die lange Finanzkrise setzt DV-Abteilungen deutscher Firmen zunehmend unter Druck. Die Misere hat Investitionen in Hardware, Software und Personal blockiert, während der Bedarf an Bandbreite und Rechenkapazität ständig gewachsen ist. Das Resultat sind Systemausfälle und Engpässe allerorts. Höchste Zeit für Renovierungsarbeiten, mit denen die Firmen ihre Netze auf die wachsende Datenflut vorbereiten!

Damit die IT-Verantwortlichen nicht im nächsten Jahr schon wieder an den Fundamenten schweißen müssen, sollten sie eine gut skalierbare Umgebung schaffen, die mit ihrer Firma wächst. Welche Methoden sie dabei wählen, hängt von den Anforderungen an die Infrastruktur ab. Ausschlaggebend ist zudem die Art der benutzten Anwendungen.

Alle Sanierungsprojekte haben als Ziel, ein kompliziertes Netzwerk radikal zu vereinfachen. Die Architekten der Umbauarbeiten wollen ein komplexes System aus Hard- und Software überschaubarer gestalten. Ihr Verfahren heißt Konsolidierung und betrifft hauptsächlich die Server und deren Betriebssysteme. Aber auch die Anwendungen.

Serverkonsolidierung heißt, viele alte Rechner durch wenige neue ersetzen. Damit die Migration funktioniert, müssen sie die Kapazität ihrer Vorgänger mindestens aufwiegen oder - besser - überbieten. Denn eine skalierbare Infrastruktur benötigt reichlich Spielraum nach oben. Während bei Unix-Rechnern die Kapazität mit dem Ausbau bis zu 64 und mehr CPUs linear ansteigt, ist bei Intel-gestützten Linux-Servern die Ausbaufähigkeit noch auf acht CPUs begrenzt. Mehr Kapazität bieten die pSeries-Server mit Risk-CPUs, die unter Linux laufen, oder die zSeries-Mainframes desselben Herstellers, die Linux auf logischen Partitionen aufnehmen.

Konsolidierung verringert auch bei den Betriebssystemen die Vielfalt: Während viele Jahre lang heterogene Systeme als gegeben akzeptiert waren, gewinnen heute die so genannten strategischen Betriebssysteme wieder an Bedeutung. Dabei spielt Linux eine tragende Rolle, so Andreas Nemeth, Leiter Professional Services bei Suse.

Er sieht die Open-Source-Plattform als wesentlichen Teil einer "Organic Information Technology". Weil sie auf allen Rechnersystemen läuft, schaffe sie zwischen der Hardware-Ebene und den Anwendungen eine bei organischen IT-Systemen typische Abstraktionsschicht. "Firmen brauchen eine einmal entwickelte Software nicht mehr zu portieren, wenn sie sie vom PC auf einen Mainframe überführen wollen", sagt Nemeth. Sein Resümee: "Jedem IT-Leiter, der zukunftssichere Entscheidungen treffen will, rate ich zu Linux."

Die Konsolidierung mit Mitteln von Linux geht dabei nicht nur auf Kosten von Windows. "Zurzeit sind Migrationen von Risk/Unix- auf Intel/Linux-Umgebungen das wirtschaftlich attraktivste Szenario", schätzt Paul Salazar, Director Marketing EMEA bei Red Hat. Intel-basierte Systeme böten dieselbe Zuverlässigkeit bei höherer Performance und geringeren Kosten unter anderem für die Hardware. Zudem sei für die Migration von Unix auf Linux meist das Know-how in den Unternehmen vorhanden.

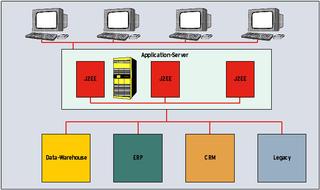

Bei den Anwendungen überarbeiten die Planer eines Konsolidierungsprojekts die gesamte Struktur - vom Server über die Middleware bis zum Client. Im Middleware-Bereich glaubt Georg Unbehaun, Leiter Communications bei Unilog, an ein wachsendes Interesse für Webservices. Kleine, mittlere und große Unternehmen würden damit am meisten Geld sparen. Klar, dass auch Sun für Java wirbt. Linux gilt dort als Einstiegsplattform. Wenn die Anforderungen an die Skalierbarkeit steigen, heißt das Mittel der Wahl Solaris.

Den Bogen zwischen beiden Betriebssystemen schlagen Anwender mit Java. Sun rät dazu, auf Webservices zu setzen, um bestehende Dienste in eine skalierbare Infrastruktur zu integrieren. Auf Client-Seite einer mit Java "webifizierten" Anwendung steht ein schlanker Desktop-Rechner, ein Thin-Client, auf dem nur ein Java-fähiger Browser läuft.

Die meisten der mit Thin-Clients gesparten Kosten sind indirekt. Sie betreffen Personalschulungen, Datenverluste bei Bedienungsfehlern und Zeitverluste durch das PC-Management in eigener Regie - so das Ergebnis einer Studie der Gartner Group zur Rentabilität von "Server Based Computing" aus dem Jahr 2002. Eine Firma mit 2500 Desktops an drei Standorten und 35 Vier-Wege-Servern in der Zentrale reduziert, auf zwei Jahre berechnet, ihre Betriebskosten um 60 Prozent, wenn sie statt herkömmlicher Arbeitsplatzrechner die dünne Variante wählt, so die Analyse.

Steve Yeo, Marketing Director für Europa und Asien bei Wyse Technology, schlägt vor, statt den Rechnerbestand aufzustocken jeden neuen Mitarbeiter mit einem Thin-Client auszustatten. Damit sich die Migration bezahlt mache, müssten die simplen Desktops gegenüber den PCs eine kritische Masse erreichen. Suse-Manager Nemeth zufolge nutzen vor allem Unternehmen mit Filialen die Web-zentrierte Technik. Dabei dienten als Application-Server Linux- oder Unix-Rechner, während Datenbanken zunächst auf den Altsystemen weiter liefen.

Eine weitere Methode für den Bau skalierbarer Server-Umgebungen fasst mehrere Rechenknoten zu einem Verbund zusammen. So wächst einerseits die Kapazität gegenüber den Einzelsystemen - im Idealfall linear mit der Zahl der Knoten. Andererseits ist ein Verbund aus vielen Rechnern sehr gut vor Ausfällen gefeit. Selbst die Störung mehrerer Teilsysteme schadet der Performance des Verbands kaum. "Modular aufgebaute Linux-Architekturen können klare Vorteile für sich verbuchen", sagt Susanne Schütz, Marketing Managerin von Dell. Sie seien erstens extrem flexibel und ausbaufähig. Und zweitens schafften sie einen nahezu beliebig erweiterbaren Hardware-Unterbau.

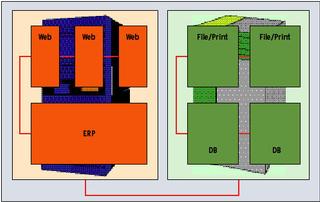

Je nach Anwendung, die auf den Servern läuft, haben sich zwei Verfahren etabliert: Loadbalancing und Clustering. Beim Loadbalancing besteht das Gesamtsystem aus vielen gleichen Knoten. Nur solche Anwendungen, die ihre Arbeitslast auf voneinander weitgehend unabhängig rechnende Server verteilen können, eignen sich dafür. Alle Client-Anfragen werden von einem Hard- oder Software-Loadbalancer gerecht an die Knoten verteilt. Vor allem Webserver-Farmen, Application-Server und Stützpunkte für das Server Based Computing wie Citrix oder Tarantella profitieren. Als Hardware dienen vergleichsweise billige PC-Server, die mit ihrem Teil der Arbeitslast gut zurechtkommen.

Ein hohes Maß an Skalierbarkeit haben laut Alfred Steinecker-Nehls, Business Manager Linux bei HP Deutschland, Blade-Server, die seiner Ansicht nach bei den Kunden mehr und mehr Interesse finden. Anbieter von Services mit stark schwankender Nachfrage, könnten damit in Spitzenzeiten ihre Kapazität schnell erhöhen. "Sie lassen ein paar Slots frei. Wenn sich in der kritischen Phase zeigt, dass die Server nicht reichen, werden neue nachgesteckt." Alle Anbieter von Blade-Servern, etwa Dell, Hewlett-Packard, IBM, RLX oder Sun, stellen mit den Geräten auch Software bereit, die ein im Hot-Swap-Verfahren eingeschobenes Blade selbstständig mit dem gewünschten Betriebssystem-Image versorgt und konfiguriert.

Alle anderen Arten von Anwendungen, die beim Betrieb auf mehreren Rechnern eine Kommunikation zwischen den Knoten erfordern, lassen sich auf Clustersystemen installieren. Je schwächer der nötige Datenaustausch, desto schneller arbeitet dabei der Verband. Typische High-Performance-Cluster mit Hunderten von Knoten und Interconnect-Systemen wie Myrinet oder Quadrix beherbergen höchst rechenintensive Applikationen, sie kommen aber im Mittelstand kaum zur Anwendung. Gefragt sind dort vielmehr High-Availability-Cluster mit wenigen Knoten, die eine Anwendung vor Ausfällen schützen.

Paradebeispiel für HA-Cluster ist der Datenbank-Cluster 9i RAC von Oracle, der bis zu acht Knoten zusammenfasst. Damit bietet er Spielraum für den Ausbau bei Bedarf. "Anwender fangen mit zwei Knoten an und fügen nach und nach weitere hinzu", beschreibt Adiva-Consultant Dirk Reuper das Vorgehen. "Sind sechs Plätze belegt, füllt man die übrigen mit stärkeren Rechnern aus." Dabei seien im Einstiegsbereich nach wie vor Zwei-Wege-Systeme Standard. Bei größeren Systemen kämen - je nach den Anforderungen der Anwender, der Art der Anfragen und Daten - auch Acht-Wege Systeme zum Einsatz.

Hewlett-Packard zum Beispiel steckt in die Xeon-Server der Reihe Compaq Proliant DL 760 bis zu acht Prozessoren. "Wer große Datenbanken zukunftssicher einrichten will", so Steinecker-Nehls von Hewlett-Packard, "sollte schon heute genug Hauptspeicher reservieren und Itanium-Rechner einsetzen."

Firmen, die sich für die Zukunft rüsten und ihr Netzwerk auf Skalierbarkeit trimmen, müssen sorgfältig planen, damit sich der Umstieg lohnt. "Wer schludert, plant womöglich einseitig, kauft Komponenten ein, die zwar preiswert, aber nicht oder nur begrenzt skalierbar sind, schätzt die Unternehmensentwicklung falsch ein oder verlässt sich auf inkompetente Partner", warnt Klaus Hild, Geschäftsführer des Systemhauses G+H Netzwerk Design GmbH. Eine Migration beginnt daher mit der genauen Analyse der Firmenanforderungen.

Nach Ansicht von Marketing-Managerin Schütz beginnt die Beratung mit Planungs-Workshops, in denen die Consulter die Wünsche des Anwenders ermitteln und Rahmenbedingungen für den Umstieg festlegen. Danach arbeiten die Berater Einzelheiten des künftigen Netzes aus, testen die Installation und führen die eigentliche Migration durch.

Hild zufolge fängt jedes Migrationsprojekt mit einer Bestandsaufnahme an. Häufig träfen die Mitarbeiter dabei gewachsene Umgebungen an, die Windows-NT-Komponenten, Windows 2000 und Netware enthalten. Solche Firmen würden mit Linux viel Geld sparen, weil sie oft die bestehende Hardware weiter verwenden könnten. Jörg Ludwig, Manager des Linux Impact Teams bei IBM, schildert ähnliche Situationen: "Alte Betriebssysteme, fehlende Middleware für Datenbanken und Webservices, Turnschuh-Infrastruktur, Windows-NT-Farmen, Windows-SQL-Server in Umgebungen mit hohem Datenvolumen, Performance-kritische Applikationen, unterentwickelte Sicherheit." Viele Migrationsprojekte würden zudem an den falschen Tools und am fehlenden Wissen der Administratoren scheitern.

Danach müsse man die aktuelle Umgebung "gerade ziehen" und alle bekannten Fehler beseitigen sowie Patches einspielen, so Hild. Der Projektplan entstehe während eines Workshops. Danach folgten Tests, das Feinkonzept, die Schulung der Mitarbeiter und ein Pilotprojekt. Und schließlich das Handbuch, der Roll-out und der Betrieb.

Nach der Analyse der bisherigen Prozesse, der bestehenden Infrastruktur und der Ziele der Firma können gemäß Peter Ganten, Geschäftsführer der Univention GmbH, verschiedene Schritte folgen. In Frage kämen zum Beispiel die Zusammenführung von Benutzerdatenbanken in ein zentrales Repository, die Konsolidierung von Servern und Diensten, das Überarbeiten von Anwendungen, die Migration von proprietären auf offene Datenbanken, die Einführung eines zentralen Server- und Client-Managements.

Um die Anforderungen eines Unternehmens genau zu bestimmen, muss das Datenaufkommen bekannt sein. Dave Hilbe, Director Research & Development bei BMC Software, sagt: "Der Schlüssel zum Erfolg einer Migration hin zu Linux ist ein fundiertes Verständnis der bestehenden Umgebung und der Arbeitslast." Zu den kritischen Daten gehörten vor allem die Auslastung zu Peakzeiten, die mittlere Auslastung und die Anforderungen an den Funktionsumfang der zu migrierenden Anwendung.

Im nächsten Schritt müssten die Planer versuchen zu verstehen, wie die migrierte Anwendung auf einer Linux-Plattform arbeiten würde. Viele Kunden sammeln in kleinen Proof-of-Concept-Projekten Erfahrung, bevor sie die gesamte Applikation umstellen. Die Architektur der künftigen Infrastruktur - ob zentrale Großrechner, Cluster oder Loadbalancing-Systeme - hängt überwiegend von der Anwendung ab: Laut Hilbe ist es wichtig zu klären, ob die Arbeitslast einer Applikation hauptsächlich von den CPUs bewältigt wird, ob sie stark Input/Output-orientiert ist oder ob sie vor allem Speicherplatz beansprucht.

Anwender von Windows-Applikationen sollten eine sanfte Migration planen, die es ihnen zu jedem Zeitpunkt des Umstiegs ermöglicht, die gewohnten Programme weiterhin zu benutzen, schlägt Ganten vor. Dazu stünden Techniken wie Microsofts Terminal-Services, Citrix, Wine oder VMware bereit. Der Vorteil einer sanften Migration liege in den geringen Schulungskosten für die Administratoren und Mitarbeiter.

HP-Manager Steinecker-Nehls: "Nach unserer Erfahrung ist eine Migration nach intensiver Planung immer sanft." Dabei räumt er ein, dass unter Linux zwar die meisten Applikationen laufen, bei den Office-Programmen, die im Brennpunkt stünden, jedoch genau untersucht werden müsse, welche Vorlagen Makros verwenden. Diese müssten sorgfältig portiert werden. Für Applikationen in Windows-Emulationen müsse das Projektteam intensiv testen.

Zu Beginn der Migration sucht das Projektteam unter allen Alternativen die lohnendste. Im Idealfall errechnet es die Zeit, nach der der Return-on-Investment erreicht wird - nämlich dann, wenn die Investition der Migration durch die geringeren Betriebskosten wieder hereingespielt ist. G+H-Chef Hild empfiehlt die ohnehin fälligen Kosten möglichst ehrlich einzuschätzen. Sie sollten nicht nur die Lizenz- und Hardwarekosten berücksichtigen, sondern auch Einsparungen an Personal und Schulungen. Keinesfalls sollte man die eigenen Möglichkeiten überschätzen oder die Betriebssicherheit in Frage stellen.

IBM-Linux-Spezialist Ludwig rät, dass Firmen weniger auf Gesamtkosten achten sollten, als auf unternehmensspezifische Größen, die sich auch künftig als Maßstab eignen. Es sei zu bedenken, dass mit dem Projekt auch kaum messbare Änderungen einhergehen.

Besonders lohnend auch für kleine Unternehmen ist nach Einschätzung von Frank Balzer, Consulting Manager bei Computer Associates in Darmstadt, der Umstieg auf ein effektives Lizenzmanagement. "Hier lassen sich schnell erhebliche Einsparungen erzielen. Es gilt, die Produkte gerade im Office-Bereich auf die jeweilige Funktion und den Arbeitsplatz abzustimmen, den Einsatz zu hinterfragen und den Nutzungsgrad zu ermitteln." Danach müssten die Planer die Hardware der PCs so gut wie möglich standardisieren und eine automatische Softwareverteilung einführen.

Auch BMC Software erwartet von einem zentralen Installationsmanagement die größten Gewinne. Und Univention-Chef Ganten glaubt, dass ein zentrales Benutzer- und Client-Management die Kosten von Administration und Helpdesk reduziert. Problematisch sei beim Berechnen des Return-on-Investment jedoch, "dass es weiche Faktoren wie Sicherheit, Stabilität und Flexibilität gibt, die selten in die Berechnungen einbezogen sind".

Auch wenn die Lage so mancher IT-Abteilung nach wie vor recht misslich ist: Investitionen für das Skalieren der IT-Landschaft sind nach einiger Zeit unumgänglich. Andernfalls lähmen Performanceprobleme und Instabilitäten das Tagesgeschäft. Linux-basierte Server, zunehmend auch Clients, sind hierbei vielfach die beste Wahl.

Für Firmen, die aus finanziellen Gründen noch keine größeren Umwälzungen in Gang setzen wollen, kommt ein Leasing-Modell in Frage. Laut Adiva-Consultant Reuper ist das Leasing von Hardware zusammen mit einem Wartungsvertrag im Mittelstand gängige Praxis. "Firmen sourcen out, wenn die IT nicht zu ihren Kernkompetenzen zählt", erklärt Suse-Manager Nemeth. Leistung mieten sei unter Kostengesichtspunkten sehr interessant. Voraussetzungen seien ein guter Vertrag und ein kompetenter, zuverlässiger Partner, der auch morgen noch im Geschäft ist. (jk)